1.1 关系数据库的基本概念与定义

关系数据库就像一本精心编排的电子账本。想象一下Excel表格,但具备更严谨的结构和更强大的关联能力。数据被组织成二维表格的形式,每张表格称为一个“关系”,行代表记录,列代表属性。这种结构让数据之间的关系变得直观清晰。

我记得第一次接触数据库时,被“关系”这个词迷惑了很久。后来才明白,它指的是表格之间通过特定字段建立的连接。比如客户表和订单表,通过客户ID这个共同字段,就能轻松找出某个客户的所有订单信息。这种设计让数据不再孤立存在,而是形成了有机的网络。

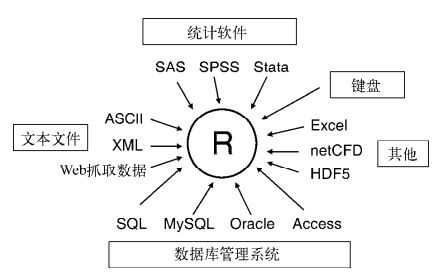

关系数据库管理系统(RDBMS)是支撑这一切的引擎。它负责存储、检索和管理这些表格数据,确保数据的完整性和安全性。市面上常见的MySQL、PostgreSQL、Oracle都属于这类系统。

1.2 关系数据库的发展历程

时间倒回1970年,IBM研究员埃德加·科德发表了那篇开创性的论文《大型共享数据库的关系模型》。这个想法在当时相当超前——用简单的表格结构代替复杂的层次结构和网状结构。

早期的数据库系统就像迷宫一样复杂。科德提出的关系模型彻底改变了这种状况。我记得有位老工程师说过,他们当年维护网状数据库时,要记住各种指针和路径,稍有不慎就会迷失在数据迷宫中。

1980年代是关系数据库的商业化黄金期。Oracle、DB2、Sybase等产品相继问世,SQL语言也逐渐成为标准。这个时期的关系数据库开始从实验室走向企业应用。到了1990年代,开源数据库MySQL和PostgreSQL的出现,让更多中小型企业也能享受到关系数据库的强大功能。

现在回想起来,关系数据库能经久不衰确实令人惊叹。它用最简单的表格概念,支撑起了半个世纪的数据管理需求。

1.3 关系数据库在现代应用中的重要性

今天,关系数据库几乎无处不在。从银行的交易系统到电商的订单管理,从医院的病历系统到学校的选课平台,关系数据库都在默默支撑着这些关键业务。

它的稳定性让人放心。我参与过一个电商项目,在促销期间每秒要处理成千上万的订单,关系数据库的ACID特性确保了每笔交易都能准确完成。这种可靠性在金融、医疗等对数据准确性要求极高的领域尤为重要。

虽然现在NoSQL数据库很流行,但关系数据库在处理结构化数据和复杂查询方面依然无可替代。它的标准化和成熟度让开发团队能够快速上手,丰富的工具生态也大大降低了运维成本。

在企业级应用中,关系数据库就像一位经验丰富的老管家,可能不够时髦,但绝对值得信赖。这种经过时间考验的稳定性,正是它在数字化时代依然占据核心地位的原因。

2.1 表、行、列的基本结构

走进关系数据库的内部世界,最先遇到的就是表、行、列这三个基础构件。它们构成了整个数据库的骨架,就像建筑中的梁柱结构。

表是数据的容器,每个表都有一个特定的主题。想象一个员工信息表,它专门存放所有员工的基本资料。这种按主题分类的设计让数据管理变得井井有条。我记得第一次设计数据库时,把不同主题的数据混在一个表里,结果查询效率低得让人抓狂。

列定义了数据的类型和约束。比如“员工姓名”列通常设置为字符串类型,“入职日期”则是日期类型。这种类型约束确保了数据的规范性。有趣的是,数据库会严格检查每个插入的数据是否符合列定义,这种严谨性避免了很多潜在的数据混乱。

行代表着一条完整的记录。在员工表中,每一行就是一位员工的完整信息。这些行在表中没有固定的顺序,数据库会根据需要重新排列它们。实际工作中,我们经常需要处理数百万行的数据表,这种无序存储的设计反而带来了更高的灵活性。

2.2 主键、外键与索引机制

主键是每条记录的身份证。它必须是唯一且非空的,确保能够准确识别每一行数据。常见的做法是用自增数字作为主键,或者使用有业务意义的字段组合。我曾经见过用员工工号作为主键的设计,这在小型系统中很实用。

外键建立了表之间的血缘关系。它像一个指针,指向另一个表的主键。通过外键,我们可以将相关的表连接起来,形成完整的数据网络。这种设计保持了数据的一致性——你不能在订单表中引用一个不存在的客户ID。

索引是数据库的快速检索系统。它类似于书籍的目录,让数据库不用逐行扫描就能快速定位数据。不过索引不是越多越好,每个索引都会占用空间并影响写入速度。一般来说,只为经常查询的字段建立索引就足够了。

2.3 事务管理与ACID特性

事务是一组要么全部成功、要么全部失败的操作集合。最经典的例子就是银行转账:扣款和入账必须同时完成,任何一个步骤失败都需要回滚所有操作。

ACID特性确保了事务的可靠性。原子性保证事务的不可分割性,就像数字世界的“全有或全无”定律。一致性确保事务前后数据库都处于合法状态,不会出现数据矛盾。

隔离性控制着并发事务的相互影响。多个事务同时执行时,隔离性确保它们不会互相干扰。持久性则承诺一旦事务提交,结果就会永久保存,即使系统崩溃也不会丢失。

这些特性组合起来,构成了关系数据库稳定运行的基石。在我经历过的系统中,正是这些机制保证了关键业务数据的安全可靠。

3.1 范式理论与数据库规范化

范式理论是数据库设计的基石,它教会我们如何优雅地组织数据。想象一下整理一个杂乱的文件柜,范式就是那个帮你分类归档的系统方法。

第一范式要求每个字段都是不可再分的原子值。比如“联系方式”字段如果同时存放电话和邮箱,就违反了这一原则。应该拆分成“电话号码”和“电子邮箱”两个独立字段。这种设计让数据查询变得更加直接。

第二范式在满足第一范式的基础上,要求所有非主键字段完全依赖于整个主键。我参与过一个项目,订单明细表最初设计为“订单ID+产品ID”作为复合主键,但把“客户姓名”也放在这个表里,这就造成了数据冗余。

第三范式进一步要求消除传递依赖。简单来说,非主键字段之间不应该存在依赖关系。比如在员工表中,“部门编号”直接决定“部门名称”,就应该把部门信息单独建表。这种规范化设计显著减少了数据更新异常。

规范化程度并非越高越好。有时为了性能考虑,我们会有意保留一些冗余,这被称为反规范化设计。关键是在数据一致性和查询效率之间找到平衡点。

3.2 实体关系模型设计

实体关系模型是数据库设计的蓝图,它用图形化的方式描绘数据之间的关联。就像建筑师在动工前先画好设计图一样。

实体代表现实世界中的对象,比如“学生”、“课程”。每个实体都有其属性,如学生的学号、姓名。确定实体时要考虑业务需求,避免过度设计。我记得有个项目开始时设计了二十多个实体,后来发现一半都用不上。

关系描述实体间的交互。“学生选修课程”就是一个典型的关系。关系的基数性很重要——一个学生可以选多门课,一门课也可以被多个学生选,这就是多对多关系。

绘制ER图时,菱形表示关系,矩形代表实体,椭圆形标注属性。这个可视化工具让设计思路更加清晰,也方便与业务人员沟通。好的ER图应该能让人一眼看懂数据的组织逻辑。

3.3 性能优化设计考量

数据库设计不仅要考虑理论完美,更要关注实际运行效率。这就像设计汽车时,既要安全可靠,也要考虑燃油经济性。

索引策略是性能优化的关键。为经常查询的字段建立索引能大幅提升速度,但索引也会增加写入时的开销。一般来说,为主键、外键和频繁查询的条件字段建立索引比较合理。联合索引的顺序也很重要,应该把最常用的字段放在前面。

分区技术能有效管理海量数据。按时间范围或业务维度将大表拆分成多个小表,可以显著提高查询性能。我们有个系统每天产生百万级数据,按月份分区后,查询速度提升了十倍。

适当的反规范化可以避免复杂的表连接。在读取频繁但更新较少的场景下,存储一些冗余数据是值得的。比如在电商系统中,订单表里直接存储商品名称,虽然违反了范式理论,但避免了每次查询都要连接商品表。

缓存机制和查询优化同样重要。合理使用数据库缓存,优化SQL语句的写法,都能带来明显的性能提升。设计时就要考虑这些因素,而不是等到系统变慢才来补救。

4.1 SQL基本语法与命令分类

SQL就像是与数据库对话的语言,掌握它就能让数据听从你的指挥。记得我第一次接触SQL时,那种能够直接从数据库中提取需要信息的感觉,就像突然获得了一把打开宝库的钥匙。

SQL命令主要分为四类:数据查询语言、数据操纵语言、数据定义语言和数据控制语言。SELECT属于查询语言,用来检索数据;INSERT、UPDATE、DELETE属于操纵语言,负责修改数据;CREATE、ALTER、DROP属于定义语言,管理数据库结构;GRANT、REVOKE则是控制语言,处理权限问题。

基本的SELECT语句结构很简单:SELECT 字段 FROM 表 WHERE 条件。但就是这个简单的结构,能够组合出无穷的变化。我教新人时总是建议从最基础的查询开始,逐步增加复杂度。比如先查所有员工信息,再按部门筛选,最后加上排序和分组。

数据类型的选择也很关键。整数、字符串、日期时间各有其适用场景。定义字段时考虑清楚数据的特性和使用方式,能避免后续很多麻烦。曾经有个项目因为把电话号码存成数值类型,导致前导零丢失的问题。

4.2 数据查询与连接操作

查询是SQL最强大的功能,而连接操作则是查询的灵魂。它让分散在不同表中的数据能够重新组合,还原出完整的信息图景。

内连接是最常用的连接方式,只返回两个表中匹配的记录。比如查询员工及其部门信息,就需要将员工表和部门表通过部门编号连接起来。这种连接方式很直观,就像拼图时只保留能完美对接的碎片。

左连接和右连接则更加宽容。左连接会返回左表的所有记录,即使在右表中没有匹配项。这在需要显示完整主表信息时特别有用,比如列出所有员工,包括那些尚未分配部门的。

多表连接时要注意性能问题。连接的表越多,查询速度可能越慢。我遇到过需要连接五个表的复杂查询,后来通过优化索引和重写查询条件,将执行时间从十几秒降到了不足一秒。

子查询和联合查询提供了更多数据处理的可能性。子查询可以嵌套在WHERE或FROM子句中,实现更复杂的筛选逻辑。联合查询则能将多个SELECT的结果合并,适合处理结构相似但来源不同的数据。

4.3 存储过程与触发器

存储过程和触发器像是数据库的自动化助手,能够在后台默默完成各种任务。它们让复杂的业务逻辑可以封装在数据库层面,减轻应用层的负担。

存储过程是一组预编译的SQL语句,可以接受参数、返回结果。它的优势在于执行效率高,而且能够实现复杂的业务逻辑。我们有个财务系统使用存储过程处理月度结算,将原本需要多个步骤的操作封装成一个简单调用。

触发器的精妙之处在于它的自动执行特性。当特定事件发生时,比如插入、更新或删除操作,触发器就会自动激活。这在维护数据一致性方面特别有用,比如在删除主记录时自动清理相关明细记录。

不过这些功能需要谨慎使用。过度依赖存储过程可能导致业务逻辑分散,难以维护。触发器如果设计不当,还可能引发意想不到的连锁反应。一般来说,我会建议把核心业务逻辑放在存储过程中,而触发器主要用于处理数据完整性和审计日志。

调试存储过程确实需要一些技巧。设置断点、单步执行、查看变量值,这些在应用开发中熟悉的概念,在数据库环境中同样重要。掌握这些调试方法,能让你更快地定位和解决问题。

5.1 数据模型差异分析

关系数据库的世界像是一个精心规划的图书馆,每本书都有固定的位置和分类。而NoSQL更像是创意工作室的白板,可以随时擦写重组。这种根本性的差异决定了它们各自的使用方式。

关系数据库严格遵循表格结构,数据被组织成行和列。每行代表一个实体,每列代表一个属性。这种结构化的方式确保了数据的一致性,但也带来了一定的刚性。记得我们有个项目需要频繁调整数据模型,每次修改表结构都需要停机维护,那种痛苦至今记忆犹新。

NoSQL数据库则提供了更灵活的数据模型。文档型数据库如MongoDB使用类似JSON的文档结构,键值对数据库像Redis使用简单的键值存储,列族数据库如Cassandra按列族组织数据,图数据库如Neo4j则专注于实体间的关系网络。这种多样性让它们能够更好地适应快速变化的需求。

数据类型处理也大不相同。关系数据库要求预先定义严格的模式,每个字段的类型、长度都有明确规定。NoSQL通常采用动态模式,允许在同一个集合中存储结构不同的文档。这种灵活性在某些场景下是优势,但也可能带来数据一致性的挑战。

5.2 适用场景比较

选择数据库就像选择工具,关键是找到适合当前任务的。没有绝对的好坏,只有是否匹配需求。

关系数据库在需要强一致性和复杂查询的场景中表现出色。金融系统、ERP系统这些对数据准确性要求极高的应用,通常都会选择关系数据库。ACID特性确保了交易的可靠性,SQL的丰富功能支持复杂的分析查询。我们公司的订单系统就基于MySQL,处理每天数万笔交易从未出过差错。

NoSQL数据库在处理大规模、非结构化数据时更具优势。社交媒体的用户动态、物联网设备的海量传感器数据、内容管理系统的多样化内容,这些场景下NoSQL的扩展性和灵活性更能满足需求。我曾经参与的一个物联网项目使用Cassandra,轻松处理了每秒数十万的数据写入。

扩展方式也影响着选择。关系数据库通常采用垂直扩展,通过提升单机性能来应对增长。NoSQL数据库则擅长水平扩展,通过增加节点来分散负载。在需要处理海量数据的互联网应用中,这种扩展方式往往更具成本效益。

5.3 混合架构的应用趋势

现在的应用很少会死守单一类型的数据库。更多时候,我们看到的是各种数据库协同工作的混合架构。这种趋势就像组建一个专业团队,让每个成员发挥自己的特长。

微服务架构加速了这种混合模式的发展。每个微服务可以选择最适合自己需求的数据库类型。用户服务可能用MySQL管理账户信息,商品服务用MongoDB存储产品目录,推荐服务用Neo4j分析用户关系。这种各取所长的做法确实提升了整体系统的灵活性。

数据同步和一致性成为新的挑战。不同数据库之间的数据流转需要精心设计。我们采用消息队列和变更数据捕获技术来保持数据同步,虽然增加了系统复杂性,但换来了更好的性能和解耦。

云服务的普及让混合使用变得更加容易。AWS、Azure这些云平台提供了各种托管数据库服务,可以按需选择、快速部署。运维团队不再需要为不同数据库的安装配置烦恼,能够更专注于业务逻辑的实现。

未来可能不会出现某种数据库一统天下的局面。更可能的是各种数据库在各自擅长的领域继续发展,通过更好的集成工具实现无缝协作。作为开发者,掌握多种数据库技术,理解它们的特性和适用场景,将成为重要的竞争力。

6.1 云数据库服务演进

云数据库正在重新定义我们使用关系数据库的方式。几年前还需要自己购买服务器、安装数据库软件的时代正在远去。现在打开云服务商的控制台,几分钟就能部署一个高可用的数据库实例,这种便利性确实改变了开发团队的工作节奏。

托管服务让数据库运维变得更加简单。自动备份、故障转移、性能监控这些原本需要专业DBA完成的工作,现在都由云服务商自动处理。我们团队最近将本地数据库迁移到云上,运维工作量减少了近七成,开发人员能更专注于业务逻辑的实现。

按需付费的模式带来了成本优化。传统自建数据库需要提前规划硬件资源,往往会出现资源闲置或不足的情况。云数据库可以根据实际使用量弹性伸缩,在业务高峰期自动扩容,闲时自动缩容。这种灵活性特别适合业务波动明显的互联网应用。

全球部署能力是另一个重要优势。云服务商在全球各地都有数据中心,可以轻松实现多地域部署。用户访问时自动连接到最近的数据节点,显著降低了延迟。对于需要服务全球用户的应用来说,这种能力几乎成为了标配。

6.2 新型关系数据库技术

传统关系数据库正在吸收其他数据库类型的优点,进化出新的形态。这种融合创新让关系数据库在保持原有优势的同时,获得了新的能力。

分布式关系数据库是个值得关注的方向。TiDB、CockroachDB这些新兴数据库在保持SQL兼容性的同时,实现了水平扩展能力。它们采用分布式架构,数据自动分片到多个节点,既保留了关系数据库的强一致性,又具备了NoSQL的扩展性。我们测试过TiDB在处理海量数据时的表现,查询性能确实令人印象深刻。

内存数据库技术正在改变数据处理的方式。SAP HANA、MemSQL这些数据库将数据完全放在内存中处理,消除了磁盘I/O的瓶颈。对于需要实时分析的应用场景,性能提升可以达到几个数量级。虽然成本较高,但在对响应时间要求极致的金融交易等场景中,这种投入是值得的。

新硬件技术也在推动数据库创新。NVMe固态硬盘、持久内存这些存储技术的进步,让关系数据库的I/O性能大幅提升。一些数据库开始利用GPU加速复杂查询,机器学习工作负载的处理效率得到明显改善。

6.3 人工智能与关系数据库的融合

AI技术正在让数据库变得更加智能。这种融合不仅仅是技术叠加,而是真正意义上的能力升级。

智能查询优化器已经展现出巨大潜力。传统优化器基于统计信息和规则进行查询计划选择,而AI增强的优化器可以通过机器学习分析历史查询模式,预测最优执行计划。实际测试中,这种智能优化在某些复杂查询场景下能将性能提升30%以上。

自动索引管理让数据库运维更加省心。系统可以自动分析查询模式,识别需要创建的索引,甚至自动删除使用频率低的索引。这种自动化不仅减轻了DBA的工作负担,还能确保索引策略始终与实际的业务需求保持同步。

异常检测和自愈能力提升了系统可靠性。AI算法可以持续监控数据库的运行指标,及时发现潜在的性能问题或安全威胁。去年我们遇到的一个慢查询问题就是被智能监控系统提前预警的,避免了一次可能的生产事故。

智能数据治理成为新的焦点。自动数据分类、敏感信息识别、合规性检查这些原本需要大量人工参与的工作,现在都可以通过AI算法自动化完成。这让数据管理变得更加高效,也降低了人为错误的风险。

关系数据库的未来不是被替代,而是进化。它正在吸收云计算、分布式计算、人工智能等领域的最新技术,变得更加强大和智能。作为开发者,我们需要保持学习的心态,跟上这些技术发展的步伐。毕竟,工具在变,但解决数据管理核心问题的目标始终如一。